Gli assistenti vocali sono sempre più presenti nelle case di tutto il mondo. Sebbene all’inizio fossero alquanto limitati, con il passare del tempo e i miglioramenti dell’intelligenza artificiale e della tecnologia, questi dispositivi sono diventati Sono usati per qualcosa di più del semplice raccontare barzellette.. L’unico inconveniente che esiste e che tutti stanno cercando di alleviare è poter interagire con l’assistente senza dover dire “Ok Google”, “Alexa” o “Ehi Siri”.

Nel caso di Google stanno facendo buoni progressi e all’ultimo Google I/O hanno annunciato “Look and Talk”, una tecnologia presente solo nel Google Nest Hub Max al momento e che permette di attivare l’assistente senza dire ‘Ok Google’ e semplicemente guardando il dispositivo. Sebbene la sua disponibilità sia ancora limitata, l’azienda ci ha offerto dettagli su come funziona questa tecnologia.

‘Guarda e parla’, una funzione per utilizzare l’assistente senza dire ‘Ok Google’

Attraverso una voce sul blog orientato all’intelligenza artificiale di Google, hanno spiegato alcuni dettagli in più su come funziona “Guarda e parla”. Ed è che perché questa tecnologia funzioni, dipende da varie tecniche di elaborazione audio e video, nonché dai sensori del dispositivo e otto modelli di apprendimento automatico per garantire che l’interazione avvenga correttamente.

L’idea con “Guarda e parla” è che puoi attivare l’assistente vocale di Google senza dire “Ok Google” e semplicemente guardando lo schermo. Google Nest Hub Max ha una videocamera, con la quale utilizza Face Match come scanner biometrico, qualcosa che combinato con Voice Match, permette di attivare l’assistente solo se rileva il nostro volto e la nostra voce.

Per far funzionare la tecnologia in modo accurato, i tuoi modelli sono stati formati per offrire una varietà di caratteristiche demografichecome l’età, il tono della pelle, ecc. Inoltre, hanno anche tenuto conto delle situazioni avverse del mondo reale, come condizioni di illuminazione non ottimali, ombre, condizioni acustiche sfavorevoli, rumore di fondo, ecc.

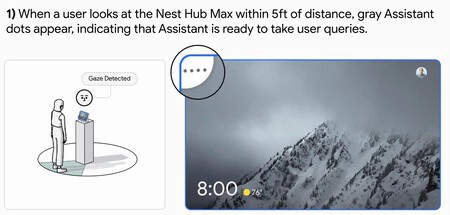

L’operazione di “Guarda e parla” passa attraverso tre fasi. Il primo è utilizzato in modo che l’assistente riconosca che l’utente intende interagire tramite segnali visivi e attivi il sistema se è il caso di ascoltare la richiesta. D’altra parte, la seconda fase è progettata per convalidare e comprendere ulteriormente l’intento dell’utente attraverso segnali visivi e acustici. È in queste due fasi che la tecnologia prende in considerazione tutti i segnali rilevare correttamente se c’è intenzione di interazione da parte dell’utentementre la terza fase ha solo lo scopo di soddisfare la query.

Come spiegano da Google, La funzione viene attivata solo se il modello rileva che vogliamo interagire con esso. Per fare ciò, la distanza del soggetto dal dispositivo, l’orientamento della testa, lo sguardo determinano se la direzione del soggetto è ottica per una conversazione attiva, ecc.

Come metodo per controllare tutti quei parametri Viene eseguita un’analisi sia del video che dell’audio. In questo modo l’assistente è in grado di rilevare se l’utente sta interagendo con il dispositivo, o con il proprio ambiente domestico (se, ad esempio, stiamo parlando con qualcuno in casa, il rilevamento dell’assistente non dovrebbe essere attivato).

Anche, vengono analizzati anche il tono di voce, la velocità e altre informazioni non lessicali per sapere se l’utente sta tentando di interrogare la procedura guidata. Per migliorare l’algoritmo, Google ha sviluppato un set di dati con oltre 3.000 partecipanti in diversi sottogruppi demografici.

Come accennato, Guarda e parla è ancora una funzionalità esclusiva di Google Nest Hub Max e è disponibile solo in inglese. Dovremo aspettare per vedere come avanza la tecnologia e se finirà per raggiungere altri territori e dispositivi.